Dark pattern: nati per disorientare

Le piattaforme digitali utilizzano spesso degli espedienti per spingere gli utenti a cedere i loro dati personali o ad acquistare determinati prodotti. Questi "dark pattern" sono in contrasto con la legislazione europea, ma le autorità faticano a contrastarli

Dark pattern: nati per disorientare

Le piattaforme digitali utilizzano spesso degli espedienti per spingere gli utenti a cedere i loro dati personali o ad acquistare determinati prodotti. Questi “dark pattern” sono in contrasto con la legislazione europea, ma le autorità faticano a contrastarli

Photo: Jan Genge/Unsplash

È capitato a chiunque di scoprire di essere iscritto a una qualche newsletter di cui non ha mai sentito parlare, o di accettare di farlo come unico modo per proseguire nell’utilizzo di un sito web o di una app, come qui:

In entrambi i casi si è stati vittime dei dark pattern, ossia quelle scelte di design delle piattaforme digitali (siti web e app) che spingono l’utente a compiere azioni che altrimenti non farebbe. Può trattarsi di espedienti grafici, lessicali, o altri elementi nell’interfaccia che in qualche modo fanno pressione sull’utente affinché si comporti in un certo modo. Può essere per esempio una casella pre-selezionata e posta al di sotto del pulsante da premere, come accade su Eventbrite:

Ma può andare anche molto peggio: provate a trovare la riga per cancellare l’abbonamento a Grammarly nell’immagine qui sotto.

Qui di seguito l’utente voleva invece disiscriversi da messaggi di marketing di Yahoo Sports. Un grosso pulsante colorato dice “No, cancel” (cancellare cosa, la sottoscrizione o la scelta di cancellarsi?), mentre le opzioni che interessano all’utente seguono in un grigino dimesso.

Si potrebbe proseguire a lungo con gli esempi, ma l’esperienza sarà familiare a qualunque lettore. Per scoprire (o segnalare) altri esempi di questo genere, può essere utile seguire l’account @darkpatterns su Twitter. Il profilo è stato creato dall’esperto di UX (user experience design) Harry Brignull, che è stato anche tra i primi a proporre una tassonomia dei dark pattern.

Si tratta di strumenti molto insidiosi perché poggiano il loro funzionamento (la cui efficacia è stata ampiamente dimostrata da diversi studi) sui pregiudizi cognitivi, ovvero tutte quelle “debolezze” che ci inducono a fare scelte non razionali, per esempio perché vogliamo liberarci di un problema fastidioso (un banner), o perché abbiamo fretta di arrivare a un certo risultato (iscriverci a un social network). La presenza di queste trappole per l’utente apre una serie di problemi, che si possono fare confluire in due grandi categorie: le scelte di acquisto e la cessione di dati personali.

I dark pattern nelle scelte di acquisto

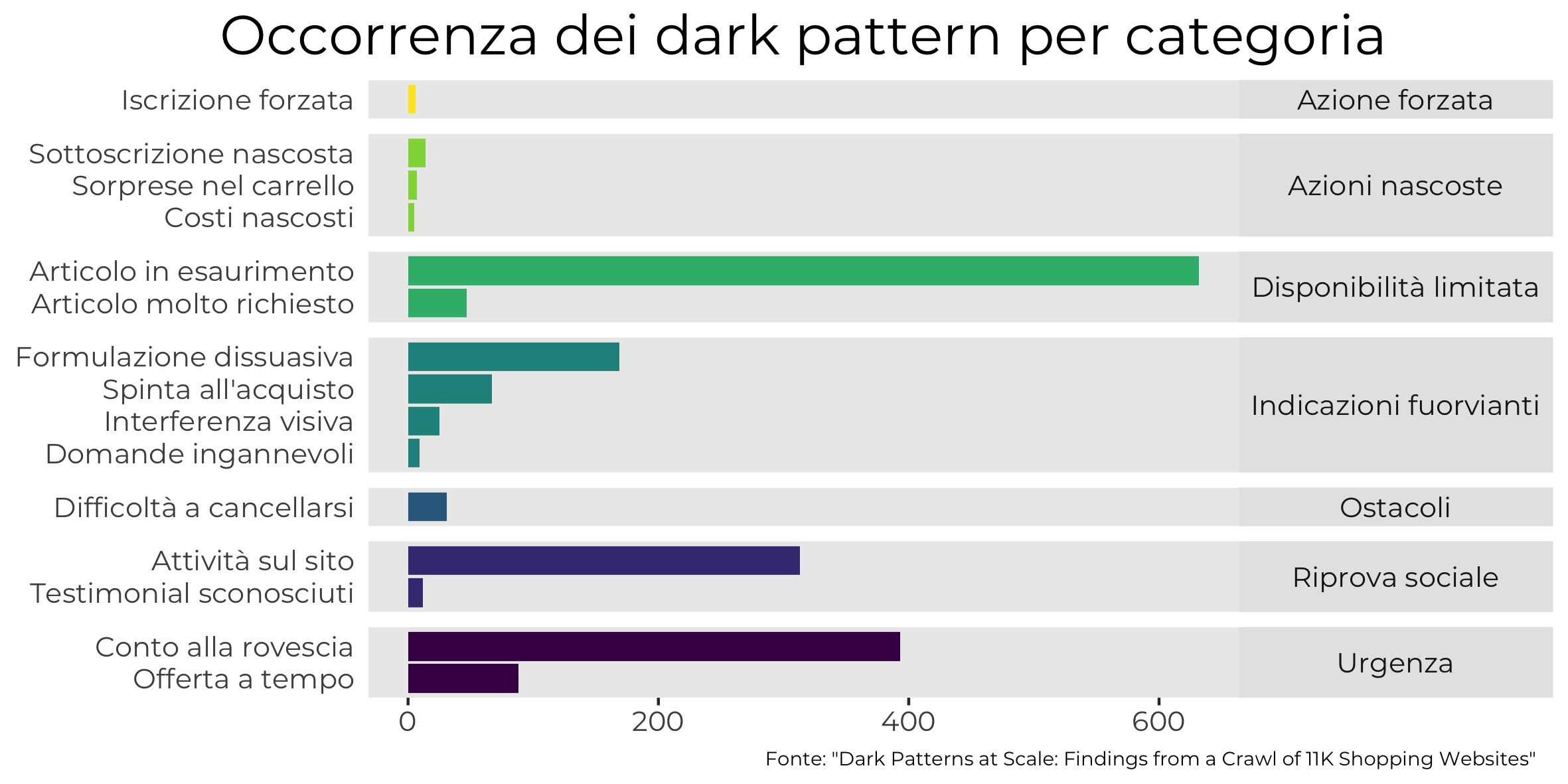

Nel primo caso il dark pattern, in maniera più o meno ingannevole, induce l’utente ad acquistare un bene o un servizio che non avrebbe voluto acquistare. Uno studio pubblicato a settembre 2019 da un gruppo di ricerca guidato da Arunesh Mathur ha rilevato 1.818 dark pattern (di cui 208 apertamente ingannevoli) distribuiti in 1.254 siti web su un campione di circa 11.000 siti, selezionati tra i più popolari secondo la classifica di Alexa.

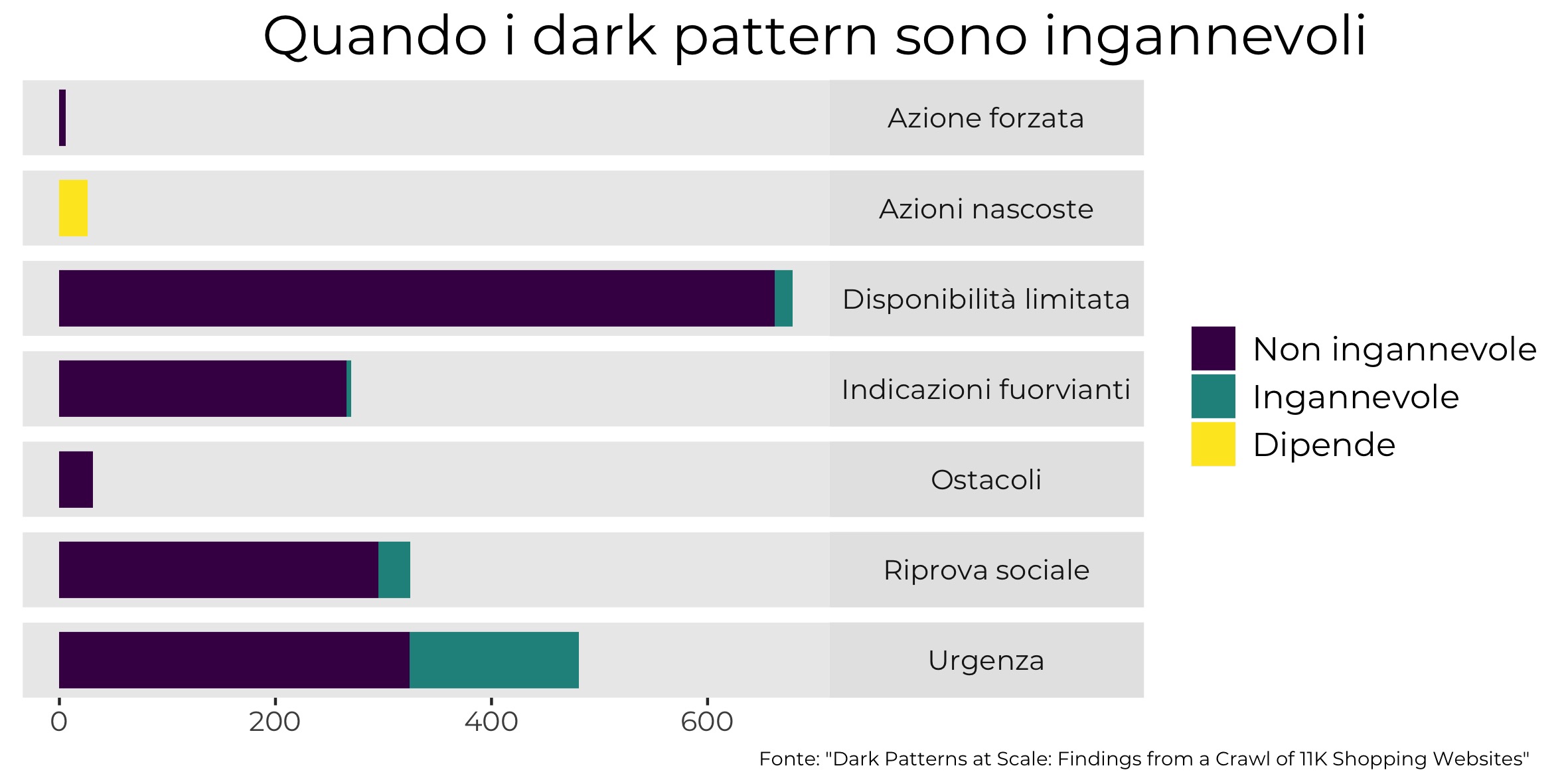

Il sistema di crawling con cui è stato condotto lo studio è stato condiviso su GitHub, in modo che altri ricercatori possano portare avanti lo studio. Il software impiegato simula il comportamento di un qualsiasi utente: sceglie dei prodotti sui siti di e-commerce, li mette nel carrello e si ferma appena prima di effettuare il pagamento. Durante il percorso vengono rilevate eventuali strategie per influenzare le scelte dell’utente, come per esempio la presenza di un conto alla rovescia che indica l’imminente fine di un’offerta. Questa tipologia di dark pattern finisce nella categoria “urgenza” (in una tassonomia che riprende in parte quella di Brignull): dei 393 timer incontrati dal crawler, quasi il 40 per cento avevano il solo obiettivo di creare pressione sull’utente, anche se l’offerta non sarebbe realmente scaduta.

Questo fa della categoria “urgenza” la più interessata dalla presenza di messaggi ingannevoli. A seguire quella della “riprova sociale”, ossia il tipo di messaggi che avvertono l’utente che un certo numero di persone sta guardando lo stesso prodotto – spingendolo a prendere una decisione prima che lo faccia qualcun altro – oppure che un altro cliente l’ha appena comprato, istigandolo indirettamente a fare lo stesso. Su 335 casi che ricadono in questa categoria, 30 (circa il 9 per cento) erano ingannevoli, perché i messaggi erano generati casualmente, solo per indurre l’utente a pensare che ci fosse molta attenzione da parte di altri sul prodotto che stava guardando.

Il limite di questa ricerca è che è stata condotta solo su istanze testuali e solo su siti web di lingua inglese. Questo ha spostato l’attenzione su siti che generalmente appartengono ad aziende extraeuropee. Analizzando però gli indirizzi, si può notare come 143 siti siano riconducibili al Regno Unito e 11 all’Irlanda. Sarebbe interessante, per studiare meglio il contesto europeo, adattare il crawler in modo da farlo funzionare in lingue diverse dall’inglese.

Dark pattern e protezione dei dati personali

Parole chiave

Il Regolamento generale per la protezione dei dati personali (2016/679), spesso abbreviato come GDPR, è una legge europea entrata in vigore nel maggio 2018. Riconosce la protezione dei dati personali come un diritto fondamentale di ogni cittadina/o.

Il concetto di privacy by design prevede che le piattaforme digitali osservino i principi della protezione dei dati dell’utente contenuti nel GDPR fin dalla fase della loro progettazione. Bisogna valutare quali possono essere i possibili rischi per la privacy nella fruizione del servizio e prendere misure preventive, in modo da evitare qualunque minaccia per l’utente.

La privacy by default invece richiede che le opzioni preimpostate dei servizi digitali siano sempre a favore della massima protezione dei dati: nessun dato non necessario deve essere raccolto, a meno che la persona non scelga volontariamente di cederlo.

Sul versante dei dark pattern usati per spingere alla cessione dei dati personali, si possono menzionare due casi principali: quello della procedura d’iscrizione a servizi come Facebook o Google e quello dei cookie banner.

Secondo un report del Forbrukerrådet, un’agenzia governativa norvegese a tutela dei consumatori, le due aziende statunitensi (e in misura minore anche Microsoft) sono intrusive “by default” per la privacy dell’utente. Nell’iscriversi ai loro servizi, una serie di opzioni preimpostate portano, in maniera più o meno esplicita, ad accettare di cedere dati che influenzeranno poi l’esperienza d’uso dei servizi. Tra le critiche contenute nel report, il fatto che si usino espressioni che non inducono l’utente verso scelte avvedute in merito ai propri dati, e anzi cercano di forzarne il comportamento. Contando sull’urgenza dell’utente di cominciare a usare il servizio, la scelta va fatta subito, e modificare le impostazioni in un secondo momento è lungo e complesso. Siamo molto lontani dai concetti di privacy by design e by default, delineati in maniera esplicita dall’articolo 25 del GDPR.

Anche per quanto riguarda il consenso all’uso dei cookie di terze parti (quelli che consentono ai siti web di condividere i dati di navigazione dell’utente con altre aziende per vari scopi, tra cui l’invio di pubblicità mirate) si verificano numerosi casi di violazione. Tra le modalità utilizzate, di seguito ne mostriamo una messa in atto da Tumblr, che costringe l’utente a spuntare oltre 350 caselle per opporsi alla condivisione dei suoi dati con le varie compagnie con cui Tumblr ha sottoscritto accordi.

È un caso estremo, ma è piuttosto comune che i siti web propongano di default opzioni che non mirano a tutelare la riservatezza dei dati dell’utente. Un’impostazione apertamente contraria al Considerando 32 del GDPR, che chiarisce che «Non dovrebbe […] configurare consenso il silenzio, l’inattività o la preselezione di caselle». Un concetto ripreso dall’articolo 4 del regolamento, dove si dice che per “consenso dell’interessato” si intende «qualsiasi manifestazione di volontà libera, specifica, informata e inequivocabile […]».

Il dark pattern in questo caso non è solo un espediente di design della pagina, ma una strategia deliberata affinché l’utente dia il consenso alla cessione di dati che non sono prettamente necessari per l’accesso ai servizi che sta sottoscrivendo. Una ricerca condotta su 80mila utenti in Germania ha dimostrato che il modo in cui vengono presentate le informazioni all’utente (lessico, grafica, posizione) influenza in maniera evidente la sua interazione con i cookie banner. I risultati dello studio sono piuttosto netti: se i siti web applicassero le impostazioni di privacy by default e specificità di utilizzo previste dal GDPR, il consenso attivo all’invio di dati a terze parti sarebbe dato da meno dello 0,1 per cento degli utenti.

Le leggi ci sono, ma a chi spetta farle rispettare?

«I principi della privacy by design e privacy by default sono componenti fondamentali del GDPR (Regolamento generale per la protezione dei dati). […] I dark pattern sono uno strumento che le compagnie usano per eludere tali principi, spingendo senza alcun riguardo i consumatori a trascurare la propria privacy e a fornire più dati del necessario. È un problema che dobbiamo affrontare». (Dall’intervento di Giovanni Buttarelli, European Data Protection Supervisor (scomparso il 20 agosto), in apertura di una tavola rotonda sui dark pattern che si è svolta il 27 aprile a Bruxelles).

Come spiega Gianclaudio Malgieri, giurista e ricercatore all’università di Bruxelles, dove si occupa anche del progetto Panelfit per lo sviluppo di linee guida sul consenso al trattamento dei dati nel campo della ricerca a livello europeo, sul versante dell’e-commerce «dark pattern è un nome nuovo per un fenomeno che già esisteva. Il diritto si occupa della sleale influenza sul consumatore da più di quindici anni, mentre prima prevaleva un approccio più liberista».

La Direttiva sulle clausole abusive nei contratti stipulati con i consumatori, approvata dall’Unione europea nel 1993 (93/13/EEC) fu un primo, timido passo a difesa del consumatore “oltre o nonostante” il consenso. «La direttiva europea 2005/29/CE ha affrontato finalmente il tema della persuasione ingannevole o aggressiva – spiega Malgieri –, in un momento in cui non c’era però ancora cognizione dei pregiudizi cognitivi del consumatore. Secondo la direttiva, le pratiche ingannevoli sono quelle che presentano informazioni incomplete, inaccurate o esagerate sul prodotto; quelle aggressive spingono in maniera più esplicita l’utente a compiere azioni che altrimenti non farebbe, e sono quindi ancora più controverse dal punto di vista deontologico ed etico. I dark pattern sono entrambe queste cose, anche se finora nessuna direttiva li menziona esplicitamente».

Una delle prime autorità europee a multare Facebook per questo tipo di pratiche è stata l’Autorità italiana garante della concorrenza e del mercato (Agcm) che, alla fine del 2018, ha inflitto a Facebook una sanzione di 10 milioni di euro per pratiche commerciali scorrette. Nel provvedimento dell’Autorità si legge che sono due i fatti contestati: 1. nella fase di registrazione l’informativa sull’uso dei dati personali è «priva di immediatezza, chiarezza e completezza»; 2. l’opzione per condividere i dati degli utenti registrati è preimpostata, senza che ci sia un consenso esplicito, e lascia solo la possibilità di fare opt-out in un secondo momento (scelta che comunque compromette la piena fruizione del servizio). Quest’ultima pratica si verifica anche nel caso dei siti esterni a Facebook che permettono di effettuare l’accesso tramite il social network (una possibilità spesso offerta anche da Google): «È un’opzione che fa chiaramente leva sull’immediatezza della scelta rispetto alla procedura standard, con una finta portabilità dei dati che spinge l’utente a cederne di non necessari».

Interessante notare come sia stata un’autorità per la concorrenza, e non per la protezione dei dati personali, a occuparsi per prima dei dark pattern. «Forse i garanti della privacy non sono abbastanza strutturati per occuparsi anche di questo – continua Malgieri –. Ho l’impressione che a livello giuridico l’Unione europea sia tutto sommato attrezzata per affrontare il fenomeno dei dark pattern, nonostante manchi una menzione esplicita. C’è un problema di intervento sui casi concreti, e in ogni caso manca una giurisprudenza significativa. Sarebbe bene che intervenissero da un lato lo European Data Protection Board (EDBP) con interpretazioni mirate sul concetto di correttezza ed esempi relativi anche ai dark pattern e, dall’altro, la Commissione Europea, che dovrebbe inserire forme di dark pattern nella lista nera delle pratiche commerciali scorrette».

Un parere condiviso da Rossana Ducato, ricercatrice all’Università cattolica di Louvain (Belgio). Secondo Ducato, una strada per uscire dall’impasse dovrebbe passare da una strategia integrata. «C’è chi pensa a un intervento legislativo ad hoc, come si è proposto negli Stati Uniti con il DETOUR Act (presentato in aprile e per ora fermo, ndr), ma in Europa non c’è un vuoto normativo. Restano però aperti vari problemi, tra cui stabilire quale autorità eventualmente dovrebbe occuparsi dell’applicazione delle norme, così come la definizione stessa e l’individuazione dei dark pattern. Ecco perché aprire un dibattito serio e allargato con tutti i portatori d’interesse, arrivando alla stesura di linee guida condivise, potrebbe rivelarsi una strategia molto più agile. Non serve l’ennesima direttiva, bisogna lavorare su applicazione delle leggi e consapevolezza dell’utente».

Uno dei problemi che limitano l’efficacia delle norme è la mancanza di una metodologia condivisa per identificare i dark pattern. È interessante in questo senso il lavoro di Claude Castelluccia, direttore di ricerca presso l’Istituto francese di ricerca sulle scienze digitali (Inria). Scopo del suo lavoro è formalizzare un sistema per determinare quando si realizza una manipolazione ai danni dell’utente, sfruttando l’approccio usato nel machine learning. Secondo la classificazione proposta dal suo gruppo di ricerca, i dark pattern che minano la privacy dell’utente ricadono negli execution attacks, ossia quelle azioni che sono rese così complicate da indurre l’utente a rinunciare a opporsi.

Una sentenza che mette in luce questo meccanismo è stata emessa a gennaio 2019 dalla Cnil (Commission nationale de l’informatique et des libertés), l’autorità francese per la protezione dei dati. La Cnil ha sanzionato Google per 50 milioni di euro, per motivi simili a quelli per cui è stata multata Facebook in Italia. In particolare, tra le pratiche contestate, c’è il fatto di rendere complicato l’accesso a informazioni fondamentali per l’utente, come lo scopo della raccolta dei suoi dati, la durata della loro archiviazione e il tipo di dati personali usati per la personalizzazione delle pubblicità. Informazioni disseminate in diversi documenti, che richiedono numerosi clic per essere raggiunte. La Cnil si è occupata di dark pattern anche in un’edizione dedicata dei suoi Cahiers, che costituisce un ottimo compendio di ciò che si sa finora sull’argomento.

—

Questo articolo è stato prodotto nell’ambito del progetto Panelfit , cofinanziato dal programma Horizon 2020 della Commissione europea (grant agreement n. 788039). La Commissione non ha partecipato alla stesura del testo e non è responsabile per il suo contenuto. L’articolo rientra nella produzione giornalistica indipendente di EDJNet.

https://www.balcanicaucaso.org/aree/Europa/Dark-pattern-nati-per-disorientare-197314